Ich muss Sie leider enttäuschen, die Geschichte ist frei erfunden.

Generative KI & Halluzinationen

Ein häufiges Feedback aus meinen KI-Workshops freut mich besonders: Teilnehmende schätzen es, nicht nur Chancen und Möglichkeiten kennenzulernen, sondern auch die Limitationen von ChatGPT & Co. Denn nur, wer die Grenzen kennt, kann diese Tools sinnvoll einsetzen.

𝐀𝐈, 𝐭𝐚𝐤𝐞 𝐭𝐡𝐞 𝐰𝐡𝐞𝐞𝐥!

Es ist mittlerweile eindeutig: Generative KI ist am Arbeitsplatz angekommen. Laut einer großflächigen Umfrage¹ aus über 50 Ländern, haben mehr als 60 % der Beschäftigten in den letzten 12 Monaten bereits generative KI genutzt – beeindruckend, wenn man bedenkt, dass ChatGPT erst vor wenigen Tagen seinen zweiten Geburtstag gefeiert hat und mittlerweile die achtmeistbesuchte² Website weltweit ist.

𝐃𝐨𝐧'𝐭 𝐟𝐨𝐥𝐥𝐨𝐰 𝐦𝐞, 𝐈'𝐦 𝐥𝐨𝐬𝐭 𝐭𝐨𝐨

Der Begriff „Halluzinationen³“ im Kontext von KI ist mittlerweile den meisten bekannt. Sprachmodelle wie ChatGPT erfinden Quellen, Informationen oder sogar ganze Geschichten. Oft geschieht dies unglaublich unauffällig – und wer das Phänomen nicht kennt, kann leicht in die Falle tappen:

Ein Anwalt in den USA⁴ nutzte ChatGPT zur Recherche nach vergleichbaren Fällen. Das endete im Gerichtssaal peinlich - keiner der von ChatGPT zitierten Fälle existierte. Wie Jonathan Frakes sagen würde: „Ich muss Sie leider enttäuschen, die Geschichte ist frei erfunden.“

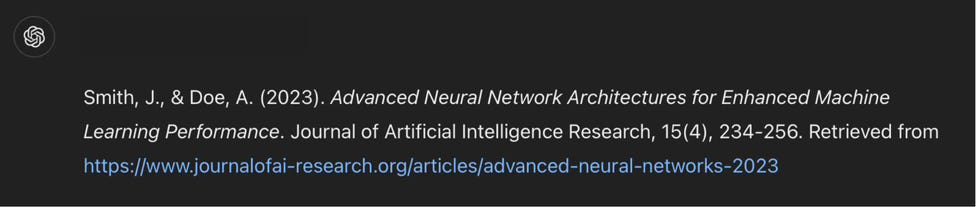

Das angefügte Bild⁵ zeigt eine perfekt zitierte Quelle. Das Problem?

Weder die Autoren, geschweige denn das Paper selbst existieren.

Auch Modelle wie Perplexity können überzeugend „lügen“ – etwa bei der Frage nach Werbespots, in denen das beworbene Produkt explizit nicht gezeigt wird. Die Antwort: Der berühmte „Hilltop“-Spot von Coca-Cola⁶. Schaut ihn euch selbst an und entscheidet, ob da wirklich keine Flasche vorkommt.

Wer diesen Modellen blind vertraut, kann unangenehm überrascht werden.

𝐃𝐢𝐞 𝐠𝐮𝐭𝐞 𝐍𝐚𝐜𝐡𝐫𝐢𝐜𝐡𝐭: 𝐄𝐬 𝐰𝐢𝐫𝐝 𝐛𝐞𝐬𝐬𝐞𝐫 (𝐯𝐢𝐞𝐥𝐥𝐞𝐢𝐜𝐡𝐭)

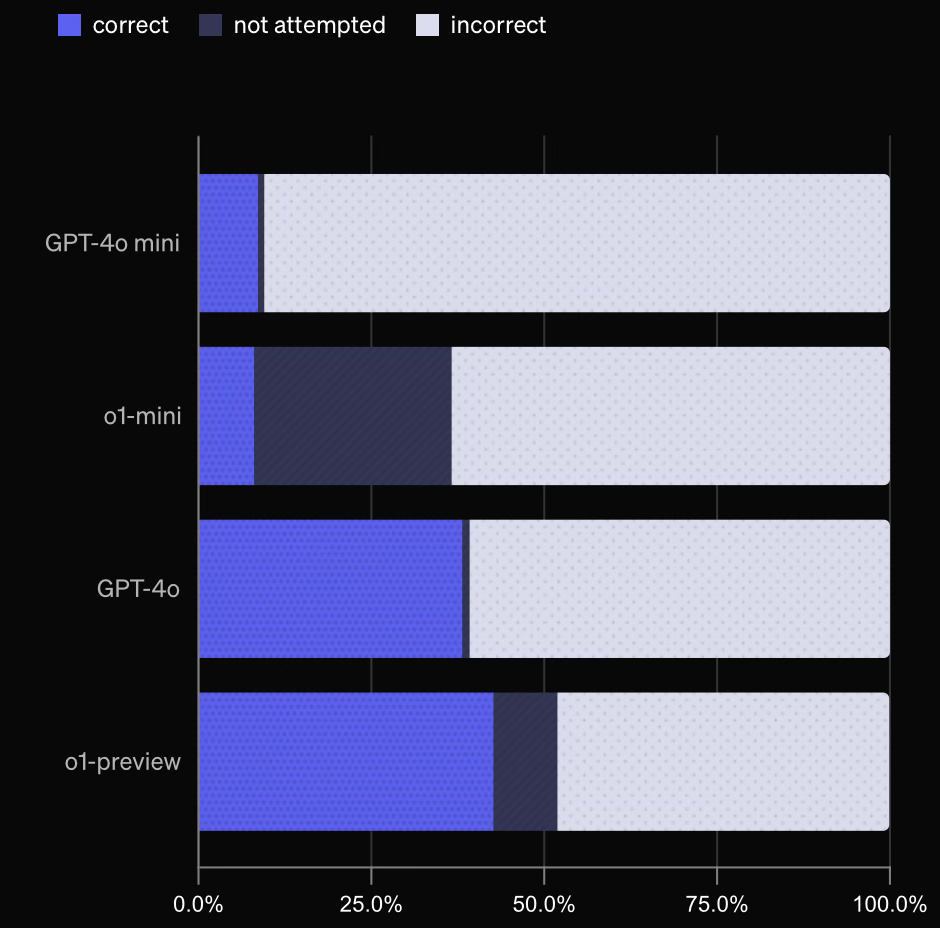

Aktuelle Tests⁷ von OpenAI zeigen, dass leistungsstärkere Modelle wie GPT-o1 weniger zu Halluzinationen neigen. Dennoch liegt die Korrektheit der Antworten auch hier unter 50 %. Bei der kostenlosen Version von ChatGPT (mit dem o1-mini-Modell) sind sogar nur etwa 15 % der Antworten vollständig korrekt. Diese Halluzinationen liegen an den faszinierenden Eigenschaften der Transformer-Architektur, auf der diese Modelle basieren und werden vielleicht nie ganz beseitigt werden. Doch den Blick unter die Haube dieser Modelle spare ich mir für einen weiteren Post. :)

𝐅𝐚𝐳𝐢𝐭

Auch mit KI bleibt eine Überprüfung der Informationen unerlässlich - denn auch nicht alles, was bei Google auf der ersten Seite steht, ist korrekt. Es bleibt unerlässlich, Informationen kritisch zu prüfen und zu validieren. Laut einer WEF-Studie⁸ zählen zwar auch AI & Big Data zu den Schlüsselqualifikationen der Zukunft, doch an erster Stelle steht das analytische Denken – die Fähigkeit, Informationen methodisch zu erfassen, kritisch zu hinterfragen und systematisch auszuwerten.

Quellen:

PwC. (2024). Hopes and Fears 2024: Workforce Transformation. Retrieved from https://www.pwc.at/de/dienstleistungen/workforce-transformation/hopes-and-fears-2024.html

Similarweb. (2024). Top Websites. Retrieved from https://www.similarweb.com/top-websites/

Metz, C. (2023, May 1). A.I. Chatbots Are Hallucinating. Here’s Why It Matters. The New York Times. Retrieved from https://www.nytimes.com/2023/05/01/business/ai-chatbots-hallucination.html

Der Standard. (2023). Anwalt blamiert sich vor Gericht mit Fällen, die von ChatGPT erfunden wurden. Retrieved from https://www.derstandard.at/story/3000000172205/anwalt-blamiert-sich-vor-gericht-mit-faellen-die-von-chatgpt-erfunden-wurden

Bild im Anhang

YouTube. (2024). Coca-Cola Hilltop Commercial. Retrieved from

OpenAI. (2024). Introducing SimpleQA. Retrieved from https://openai.com/index/introducing-simpleqa/

World Economic Forum. (2023). Future of Jobs Report 2023. Retrieved from https://www3.weforum.org/docs/WEF_Future_of_Jobs_2023.pdf